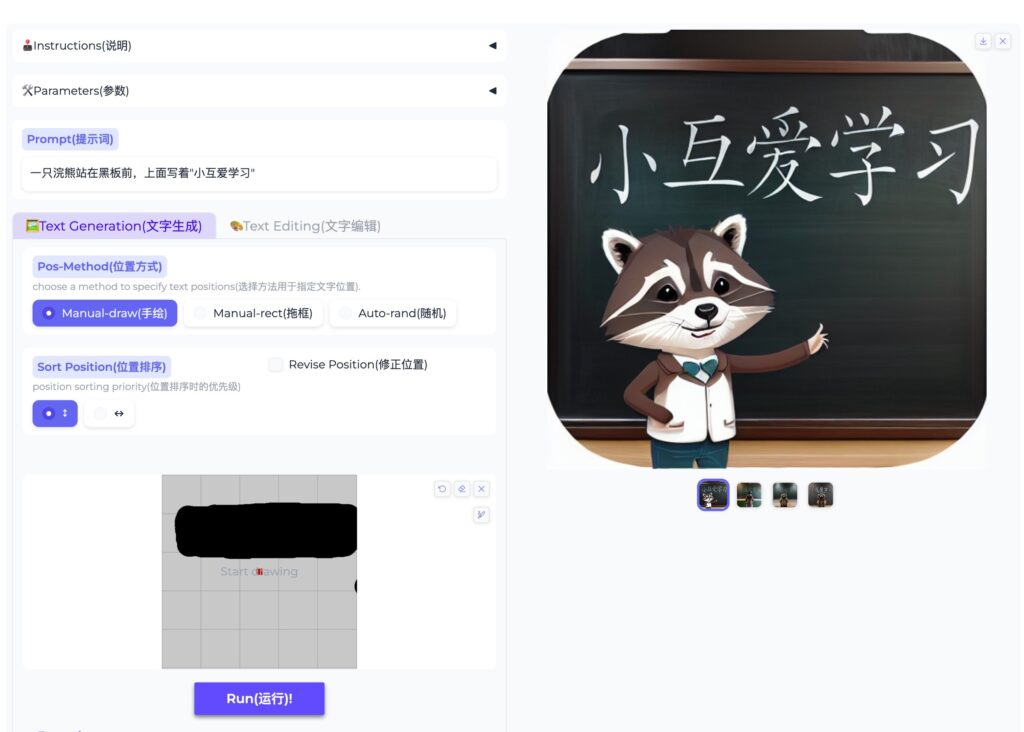

该项目由阿里巴巴开发,AnyText支持在图像中生成和编辑多种语言的文本,使其与背景无缝融合。

该模型还解决了合成文本中模糊、不可读或错误字符的问题。

AnyText可以与现有的扩散模型集成,用于准确渲染或编辑文本。

AnyText能够在图像中高度精确地生成或编辑文本。例如,它可以在一张照片中添加逼真的文本标签,或者更改图像中现有文本的内容,同时保持自然的外观和与背景的一致性。

能够处理和生成多种不同语言环境下的文本。它可以生成包括中文、英文、日文、韩文等在内的多种语言的文本。

AnyText的组成部分:

1、辅助潜在模块

功能:这个模块负责生成图像中文本的潜在特征。它使用文本字形(即文本的视觉表示)、文本在图像中的位置和遮罩图像(可能用于指示文本应该出现的区域)作为输入。

作用:通过分析这些输入,辅助潜在模块能够理解文本应该如何在特定图像中呈现,包括文本的样式、大小和位置。这对于在图像中生成新文本或编辑现有文本至关重要。

2、文本嵌入模块

功能:这个模块结合了OCR(光学字符识别)模型编码的笔画数据和图像标题嵌入。OCR模型提取图像中现有文本的特征,而图像标题嵌入则提供了图像内容的语义理解。

作用:文本嵌入模块将这些信息融合在一起,生成与图像背景和上下文无缝融合的文本。这意味着生成的文本不仅在视觉上与背景匹配,而且在语义上与图像的整体主题一致。

AnyText还提供的一个大规模多语言文本图像数据集:

AnyWord-3M数据集

数据集规模:包含约303万个图像-文本对,涵盖多种语言。

文本行和字符统计:中文:约290万行文本,包含约1509万个字符。

英文:约627万行文本,包含约635万个字符。

其他语言:包括日文、韩文、阿拉伯语、孟加拉语和印地语,共约1.17万行文本,约5.95万个字符。

OCR注释:数据集中的图像-文本对都带有OCR(光学字符识别)注释,这有助于训练和评估文本生成模型。

多语言支持:数据集支持多种语言,包括中文、英文、日文、韩文、阿拉伯语、孟加拉语和印地语,使其适用于多语言视觉文本生成和编辑任务。

GitHub:https://github.com/tyxsspa/AnyText

论文:https://arxiv.org/abs/2311.03054

ModelScope 在线演示:http://modelscope.cn/studios/damo/studio_anytext

HuggingFace 在线演示:http://huggingface.co/spaces/modelscope/AnyText