Meta 的 FAIR 团队新发表了一项名为 Chameleon 的研究。

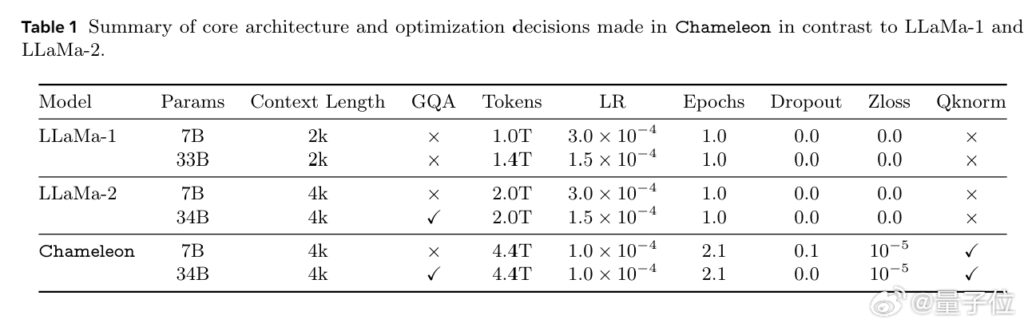

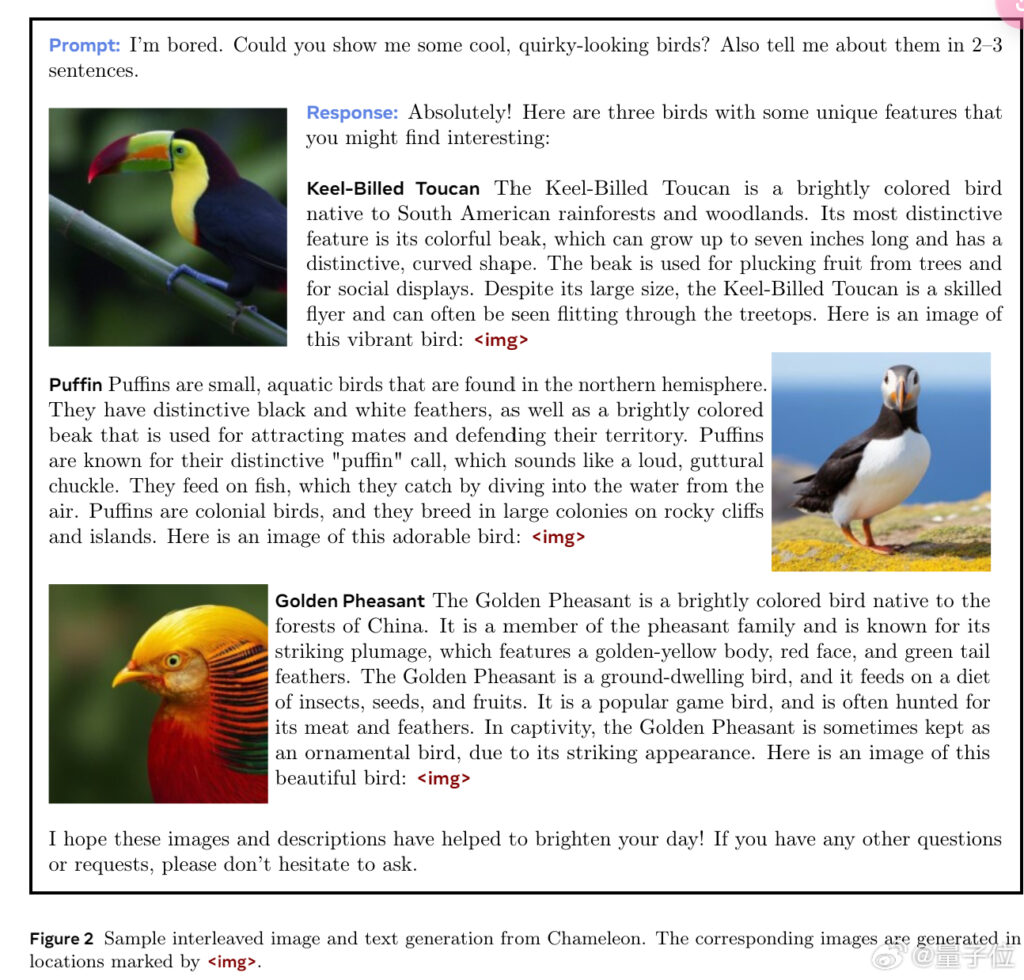

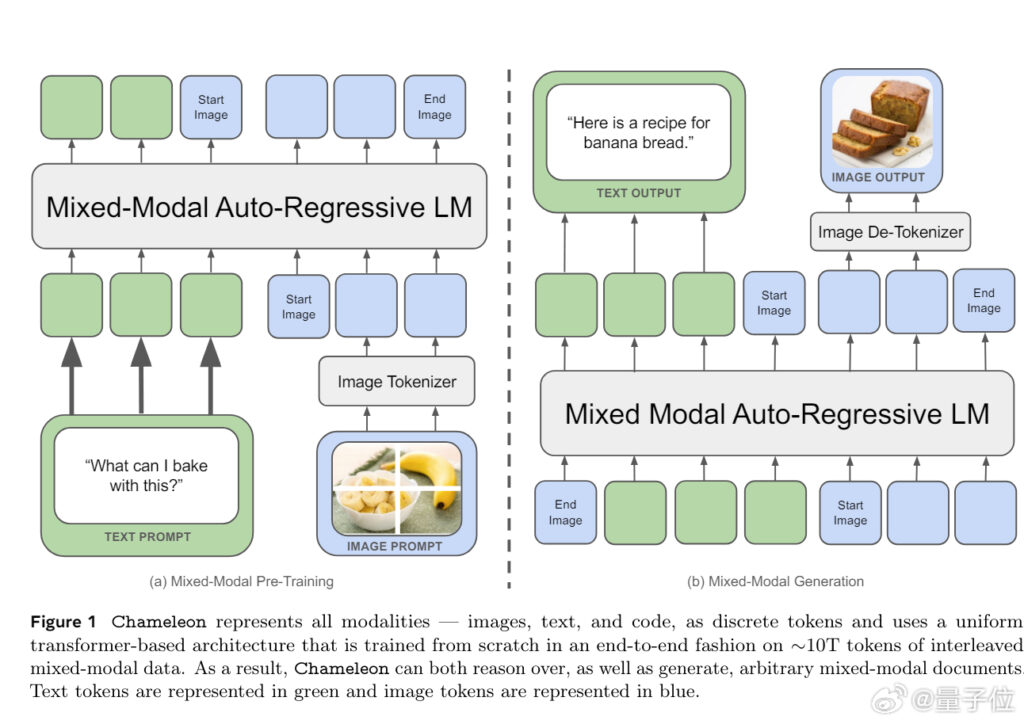

该研究开发了一系列早期融合的混合模态基础模型,能够以任意顺序理解和生成图像和文本。

该模型在综合任务上进行了评估,包括视觉问题回答、图像描述、文本生成、图像生成以及长篇混合模态生成。

经过对比,Chameleon 在纯文本任务中优于 Llama-2,并且能够与 Mixtral 8x7B 和 Gemini Pro 等模型竞争。

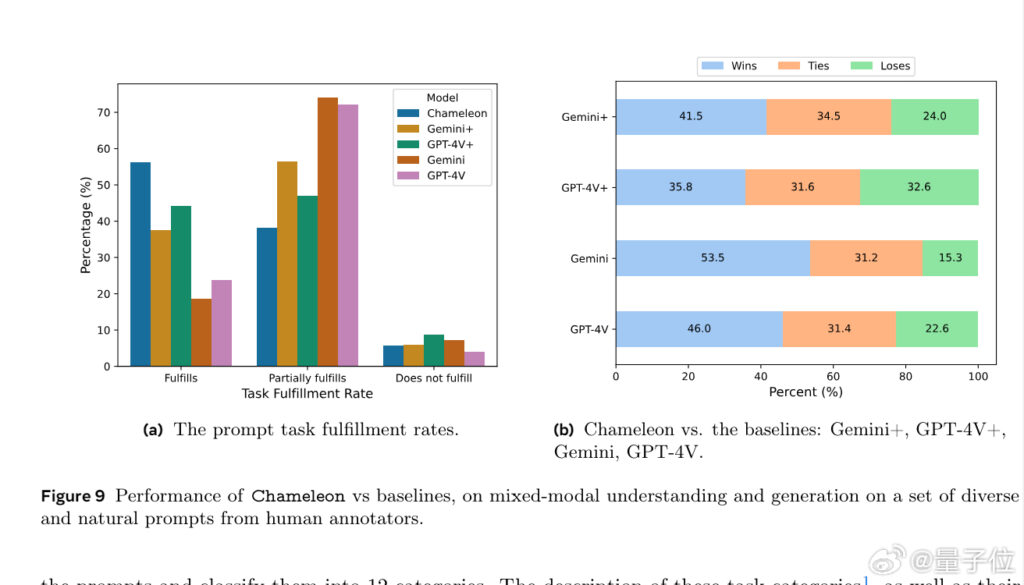

此外,Chameleon 还进行了人类评估实验,通过测量对开放式提示的混合模态长形式响应的质量来进行。

Chameleon 34B 在与 Gemini Pro 和 GPT-4V 等强基线模型的比较中显著胜出,实现了 60.4% 对 Gemini-Pro 和 51.6% 对 GPT-4V 的人类偏好率。

论文:网页链接