清华类脑计算研究中心施路平团队新成果,登上最新一期Nature封面。

团队研发出世界首款类脑互补视觉芯片——“天眸芯”。

“天眸芯”实现了一种基于视觉原语的互补双通路类脑视觉感知新范式,模仿了人类视觉系统特征。

性能上,“天眸芯”能够以每秒10000帧的高速、10bit的高精度、130dB的高动态范围进行视觉信息采集,并大幅减少带宽需求。

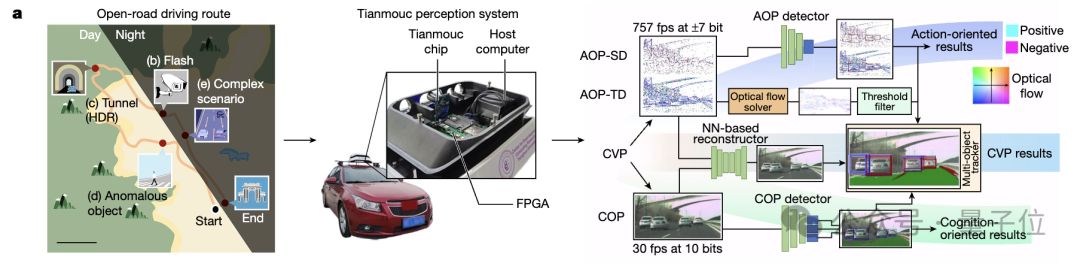

△图源:清华大学官方公众号

将“天眸芯”集成到自动驾驶系统中,即使面对突然闪光干扰、隧道等高动态范围场景、异常物体移动等复杂情况,配合互补多通路算法,系统也能实现精准认知和快速响应。

这回是真开“眸”了~

“天眸芯”长啥样?

随着自动驾驶、机器人、AI等开放世界应用的发展,现有图像传感器面临诸多挑战,难以处理超出其传感范围的动态、多样化和不可预测的情况。

比如快速骑自行车的人、意外行为、光线从明亮到阴暗的快速变化……

然鹅,图像传感器要向高速度、高分辨率、大动态范围和高精度发展,还受功率和带宽限制。

反观人类视觉系统(HVS),具有超强的适应能力和鲁棒性。

人类视觉系统将视觉刺激解析为多种视觉原语,比如颜色、方向、动作等,并以互补的方式将它们分配到腹侧路径(what)和背侧路径(where、how)这两条神经通路,有效地提供了视觉场景的统一表征。

受此启发,清华类脑计算研究中心团队提出了一种基于视觉原语的互补双通路类脑视觉感知范式。

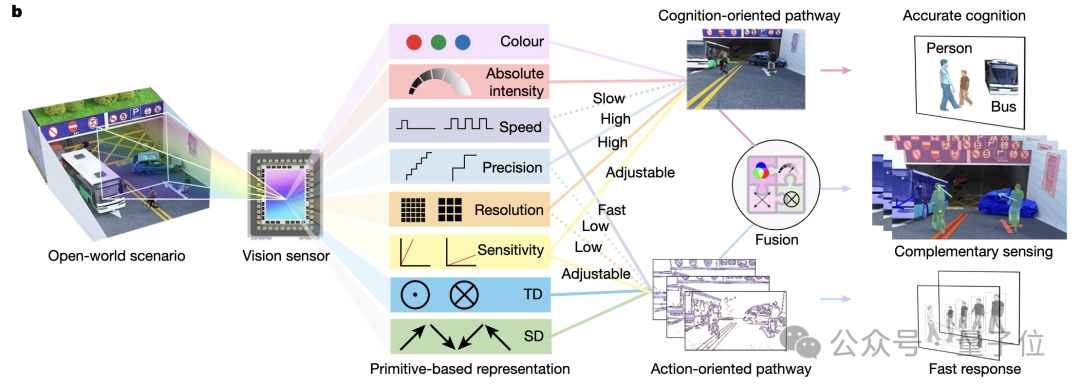

如下图所示,此范式中的原语包括颜色、精度、灵敏度、空间分辨率、速度、绝对强度、空间差分(SD)和时序差分(TD)。

两条互补的视觉路径(CVP)为面向认知的路径(COP)和面向行动的路径(AOP),对应人类视觉系统的腹侧和背侧路径。

COP使用颜色、强度、高空间分辨率和高精度的原语来实现准确的认知,最小化空间混叠和量化错误;AOP使用SD、TD和高速度的原语来实现快速响应。

为实现上述范式,研究团队设计了视觉芯片“天眸芯”。

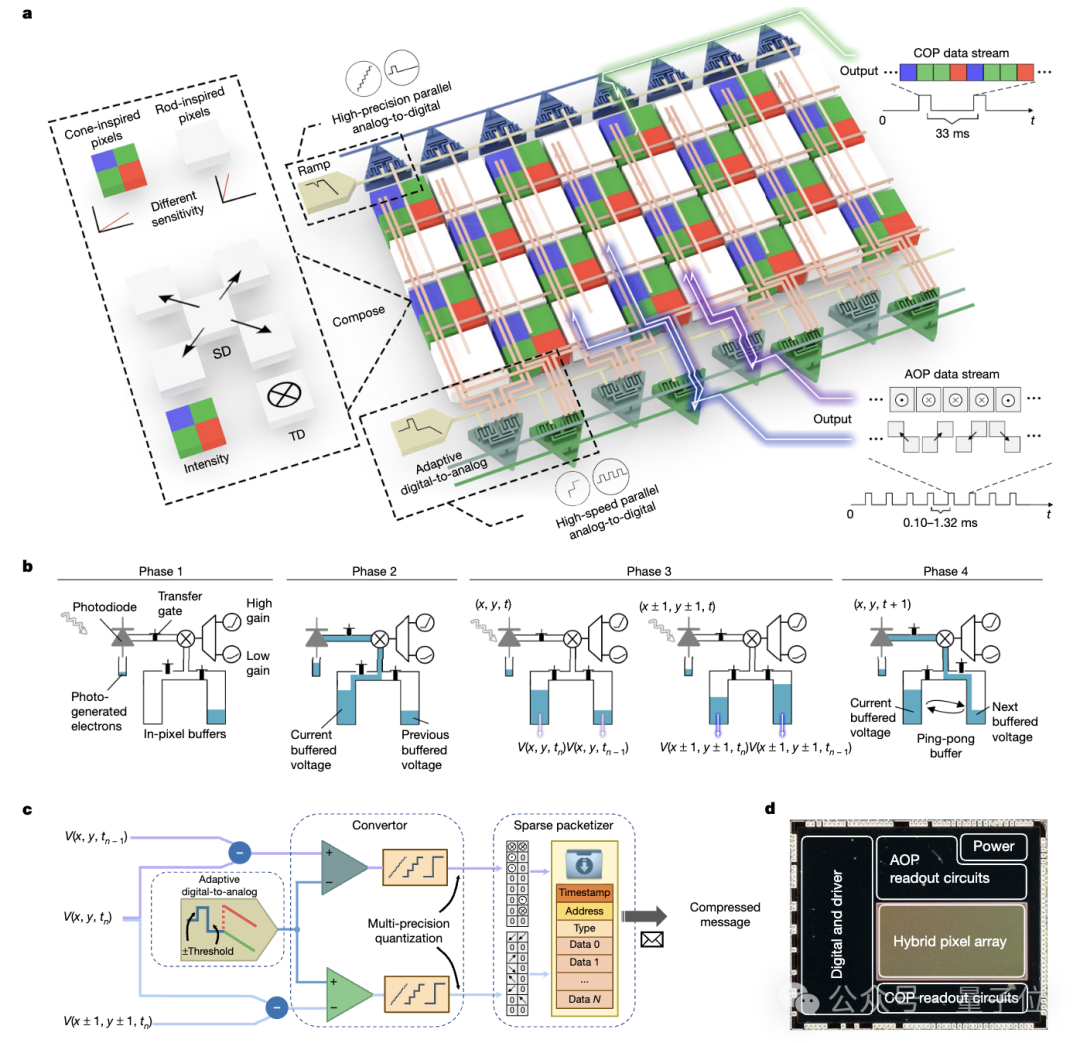

“天眸芯”整体架构设计如下图所示,包含两个核心组件:

- 混合像素阵列(Hybrid Pixel Array),用于将光学信息转换为电信号;

- 并行异构读出架构(parallel-and-heterogeneous readout architecture),用于构建两条互补视觉路径。

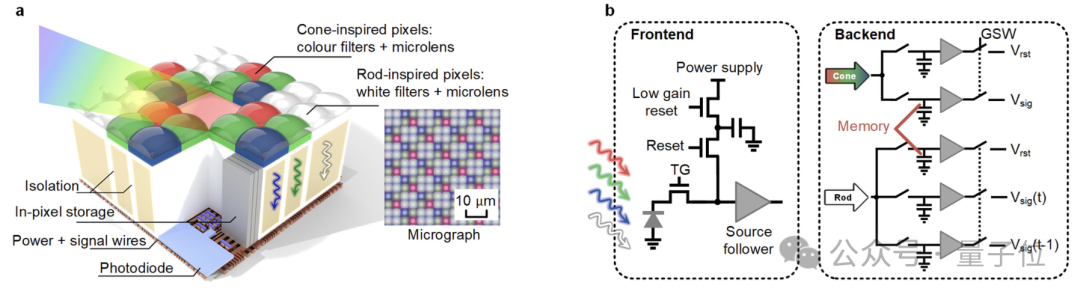

其中,混合像素阵列由锥状像素和杆状像素组成,具有不同的颜色、响应模式、分辨率和灵敏度特性。

这些像素可以将视觉信息解析为特定颜色(红、绿和蓝)和白光谱,作为颜色对立原语,还可以通过使用高增益或低增益的电荷转换模式来调节灵敏度,扩展动态范围。

锥状像素采用4μm的细粒度间距实现绝对强度感测,杆状像素有两种不同的8μm和16μm的感受野(指一个神经元或神经元集群能够响应的特定区域内的刺激),用于检测时序差分和空间差分。

此外,杆状像素内嵌高密度存储器,使用“乒乓行为”(ping-pong behaviour)缓冲历史电压,以连续计算时序差分。

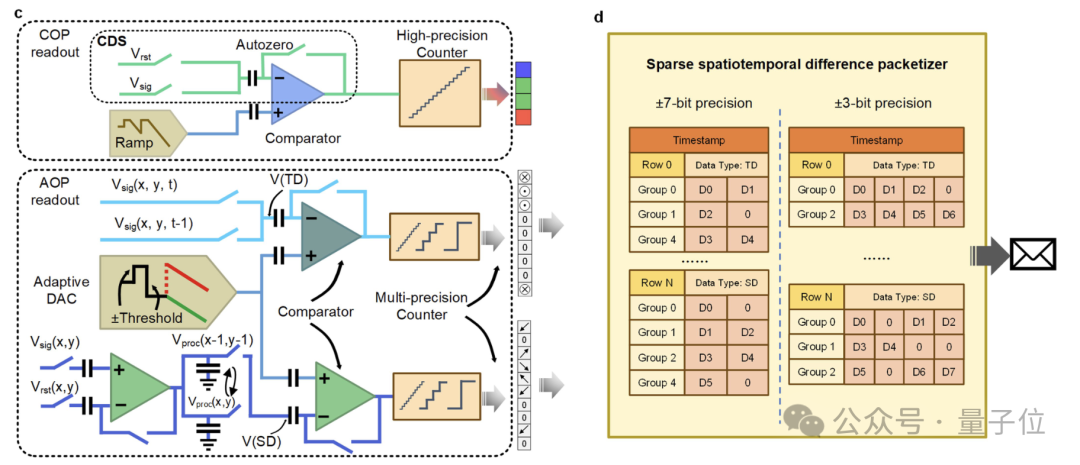

再来看并行异构读出架构。

其中,COP采用单斜率模数转换器,对密集的绝对强度信号进行高精度编码。

AOP使用专门的读出架构,通过可编程阈值滤波器(programmable threshold filter)来最小化冗余和噪声,同时保留关键信息;采用具有可配精度的快速自适应数模转换器(fast polarity-adaptive digital-to-analog converter)进行信号量化;使用数据打包器(data packetizer)实现稀疏可变精度时序差分和空间差分信号的无损压缩,以统一协议进行打包。

并行读出电路分别对应COP和AOP,COP使用高精度并行ADC,AOP使用多精度自适应ADC和稀疏编码器,支持可重构速度/精度并减少带宽需求。

高速度、高动态范围、低带宽

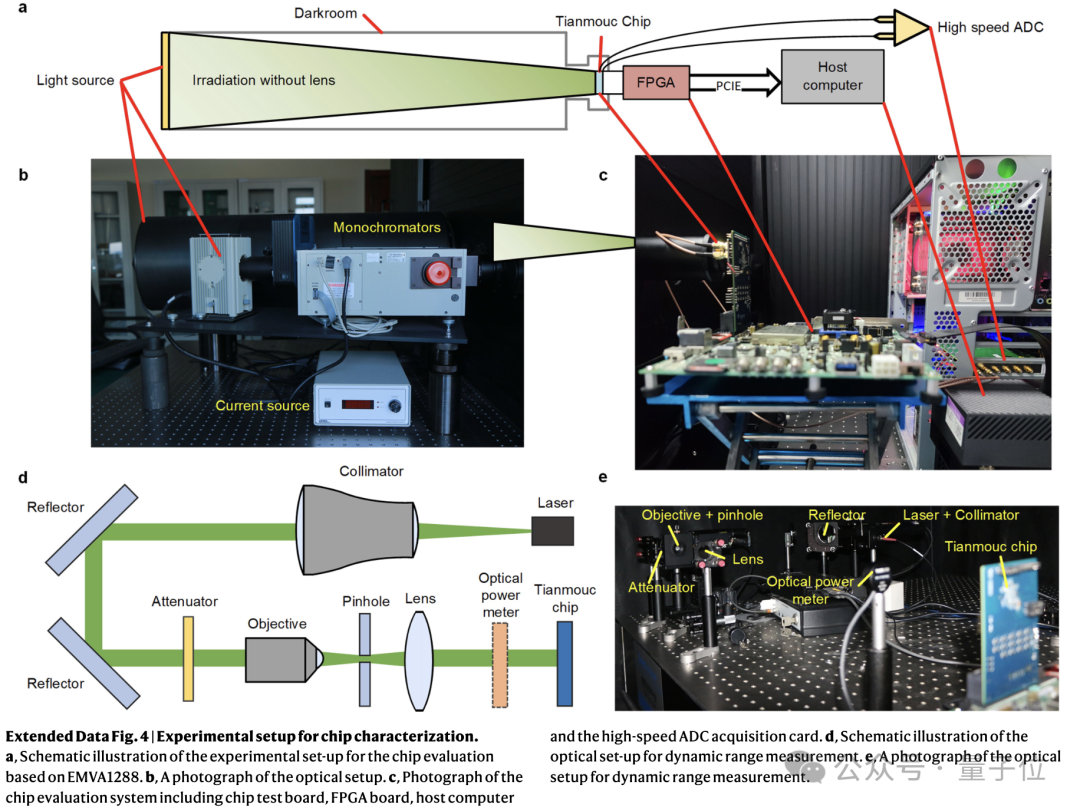

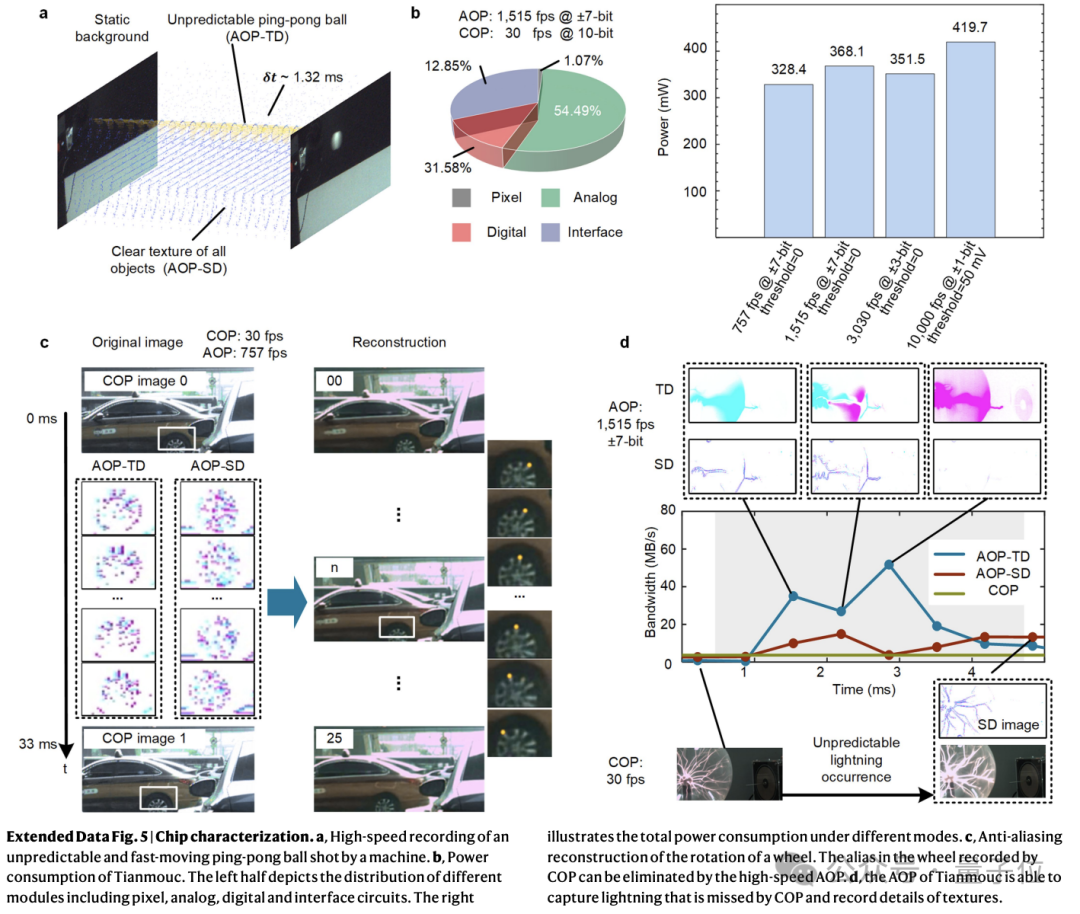

研究团队从量子效率、动态范围、响应速度、功耗和带宽等关键性能指标上对“天眸芯”的进行了全面评估。

“天眸芯”在COP和AOP两个路径上都展示了高量子效率,在530nm波长下,AOP的量子效率最大值达72%,而COP达到69%。

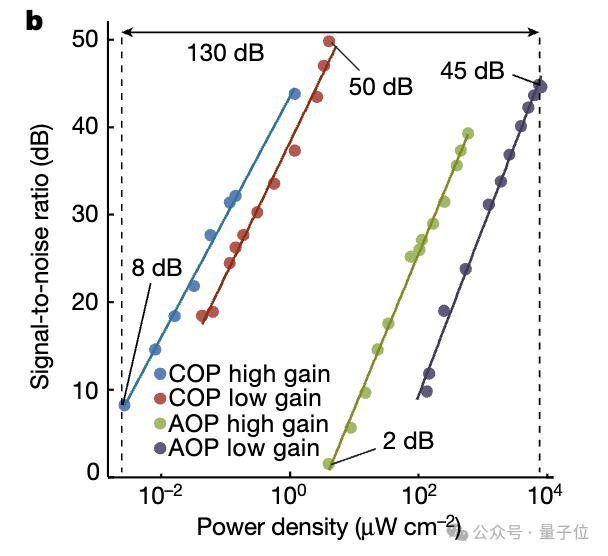

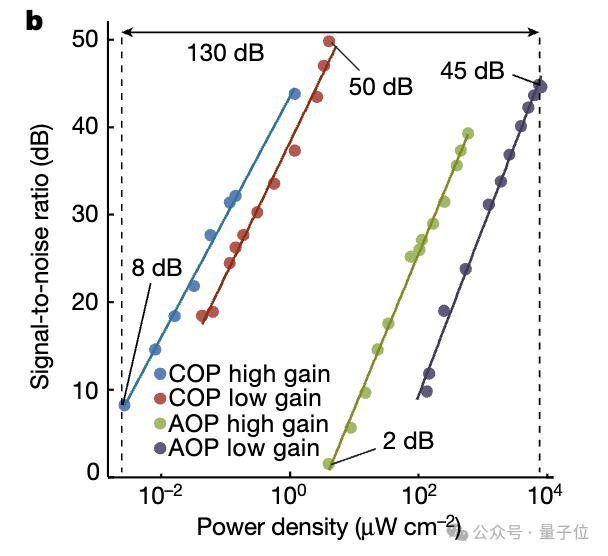

通过COP和AOP不同增益模式的动态范围叠加,“天眸芯”实现了130dB的整体动态范围。它能检测从2.71×10^-3 μW/cm^2到8.04×10^3 μW/cm^2的光功率密度。

该动态范围测试遵循EMVA1288标准,使用了专门设计的均匀光源和滤光装置。

此外,“天眸芯”展现出了高空间分辨率和精度,以及在不可预测环境中的高鲁棒性。

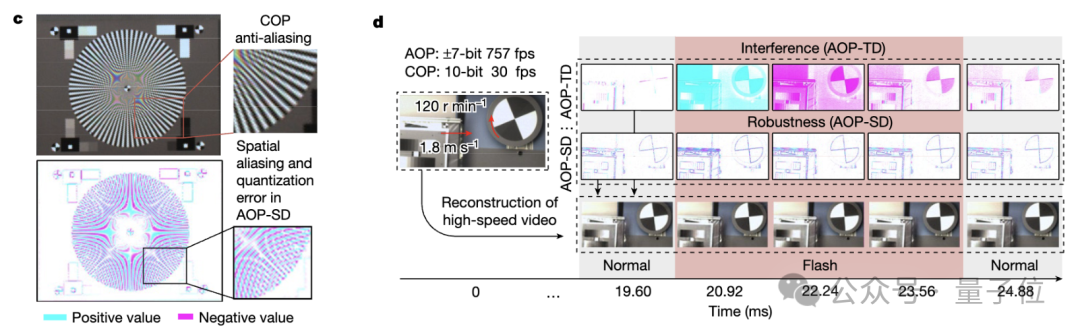

在具有快速运动、旋转和突变光照的极端场景中,COP和AOP能对视觉信息进行互补感知和重建。比如,为消除AOP中由运动引起的空间混叠和量化误差,“天眸芯”利用COP的高空间分辨率和精度进行补充。

响应速度方面,AOP可重构速度范围从每秒757帧到10000帧,精度从±7bit到±1bit,补充了COP每秒30帧和10bit分辨率相对较慢的速度。

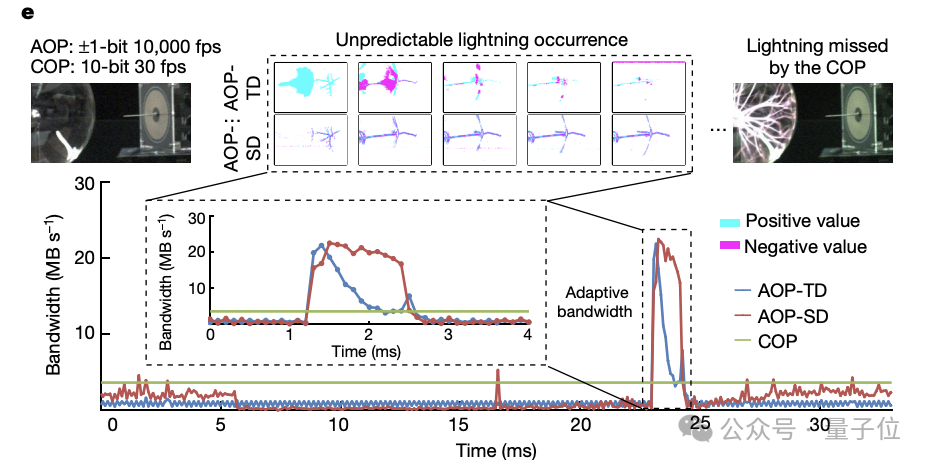

在瞬态闪电测试中,“天眸芯”能够以±1bit在50毫伏的阈值下以10000fps的速度捕捉快速闪电。

由于高稀疏性,AOP在瞬态现象期间的峰值带宽消耗仅约50兆字节每秒(MB s^-1),与具有相当时空分辨率和精度的传统相机相比,减少了90%(640×320×10000×2)。

更多高速响应演示:

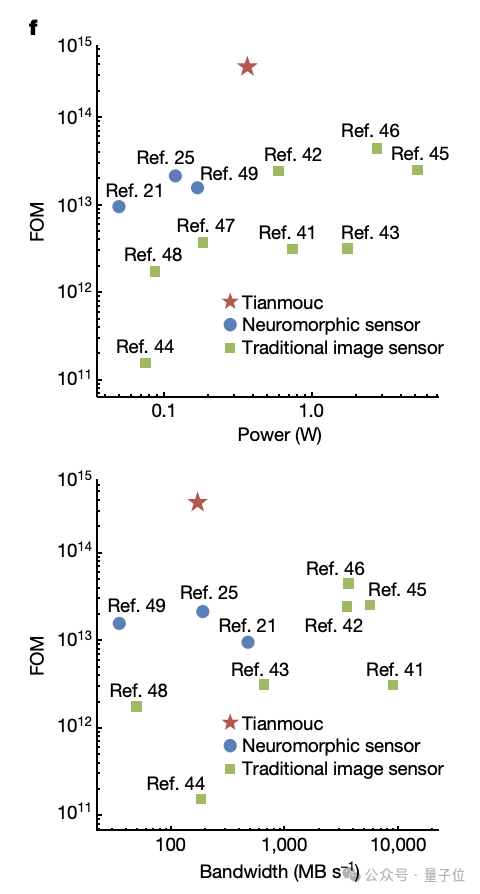

研究团队还使用一个综合的性能评估指标(FOM),结合最大采样率和动态范围,以衡量芯片的整体性能。

“天眸芯”在FOM方面表现出色,超越了现有的神经形态传感器和传统图像传感器,同时保持了低功耗和低带宽消耗。

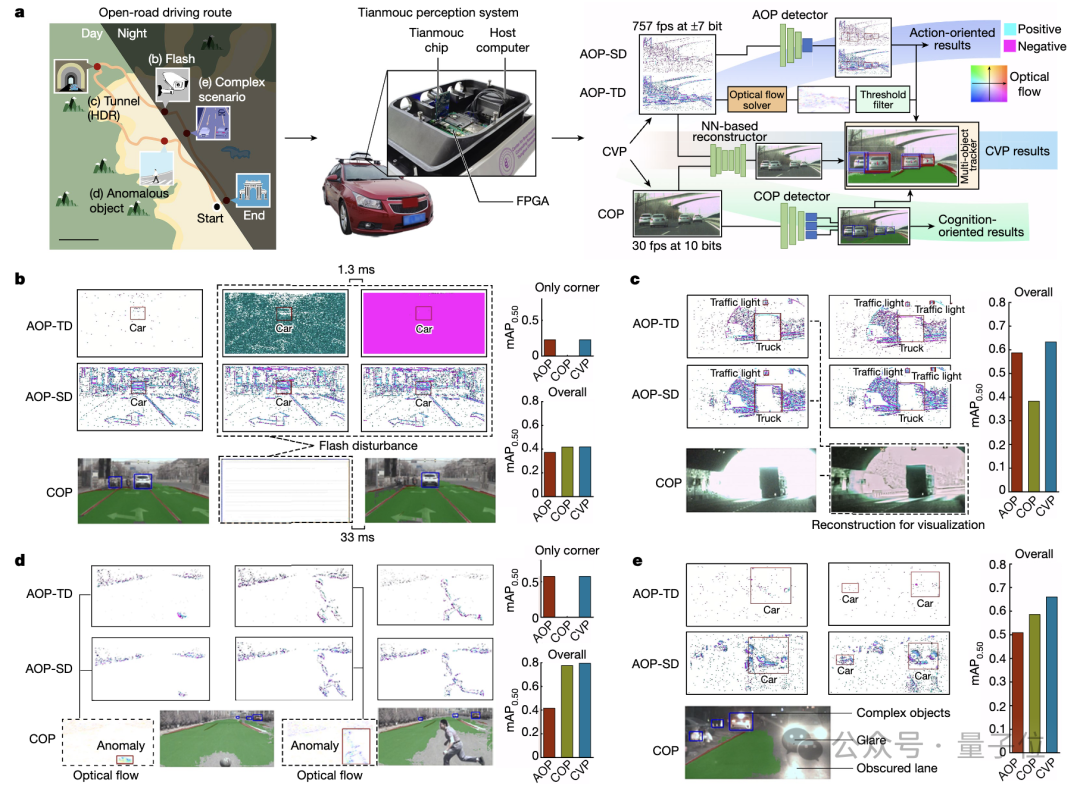

为测试天眸芯在开放世界场景下的性能表现,研究团队开发了一个集成了“天眸芯”的自动驾驶感知系统,用于在开放道路上进行评估。

评估涵盖了多种复杂场景,包括:突发的光照变化,如闪光灯干扰;高动态范围场景,如隧道入口和出口;领域偏移问题,涉及异常物体的检测;多种角落。

为充分利用天眸芯架构的优势,研究团队设计了一个多路径算法,专门针对“天眸芯”的AOP和COP互补特性进行了优化。

当场景涉及突然光闪,“天眸芯”在这种光闪情况下表现出了显著的抵抗力,同时在正常情况下保持高感知性能。

对于实时高动态范围感知,两条路径的互补灵敏度使得“天眸芯”能够感知高亮度对比度而不牺牲速度。AOP-TD和AOP-SD的协作,使得系统能够精确计算运动方向和速度,以识别异常物体。

此外,天眸芯能够同时处理多个角落案例,通过CVP的合作,提供多样化的结果,为进一步决策提供空间。

研究团队使用平均精度均值(mAP0.50)来评估算法性能。CVP在所有案例中都显示出比单一路径更优越的整体检测性能。

而且“天眸芯”在测试中消耗的带宽不到80MB/s,平均功耗为328毫瓦,这证明了其在保持高性能的同时,也实现了低功耗和低带宽消耗。

总的来说,实验结果表明,天眸芯能够高效适应极端光照环境,并提供领域不变的多级感知能力,这对于自动驾驶系统在开放世界中的性能至关重要。

清华类脑计算中心再进击

该研究来自清华大学类脑计算中心团队,论文通讯作者为施路平教授和赵蓉教授。

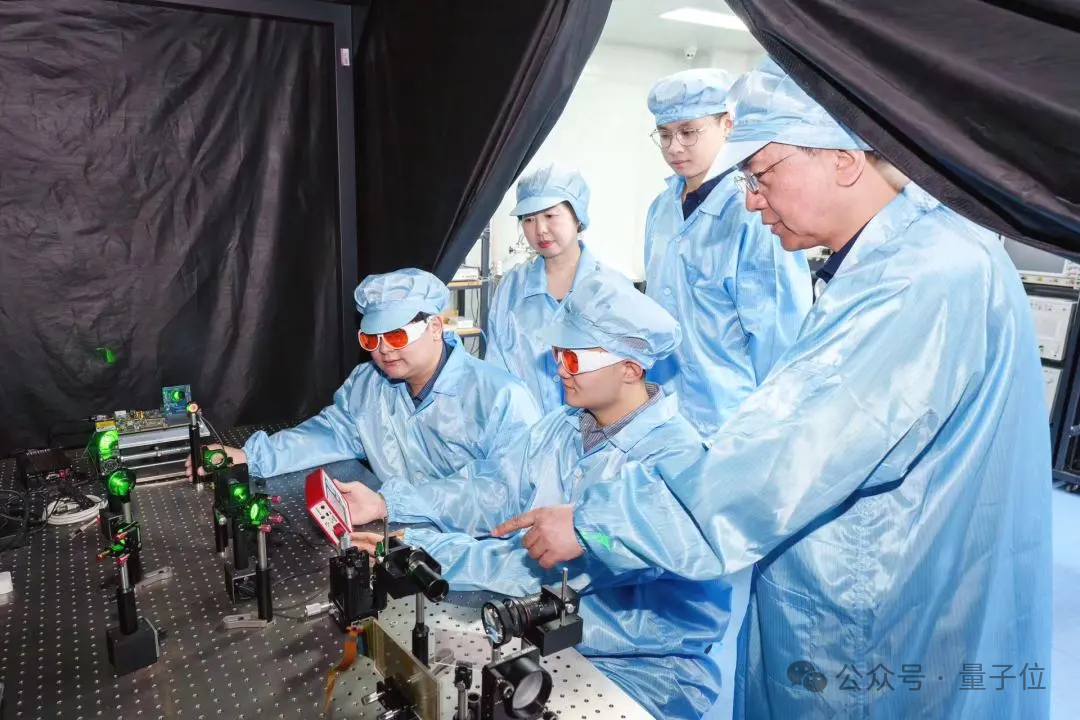

△施路平教授(右一)和赵蓉教授(左二)指导学生实验,图源:清华大学官方公众号

精密仪器系杨哲宇博士、精密仪器系2020级博士生王韬毅、林逸晗为论文共同一作。

△天眸芯研究团队,图源:清华大学官方公众号

清华大学类脑计算中心由施路平教授2013年3月全职入职清华大学后组建,从基础理论、类脑计算系统芯片和软件系统全方位进行类脑计算研究。

在最新“天眸芯”这项成果中,北京灵汐科技有限公司为合作单位,论文共同一作杨哲宇现为北京灵汐科技有限公司研发经理。

在“天眸芯”之前,清华大学类脑计算中心团队还在2019年凭借异构融合类脑计算“天机芯”登Nature封面。

顺便一提,与“天眸芯”同一天,清华还有一项研究登Nature。中国科学院院士、清华大学交叉信息研究院教授段路明带领研究组首次实现基于数百离子量子比特的量子模拟计算。

Nature审稿人称其是量子模拟领域的巨大进步。