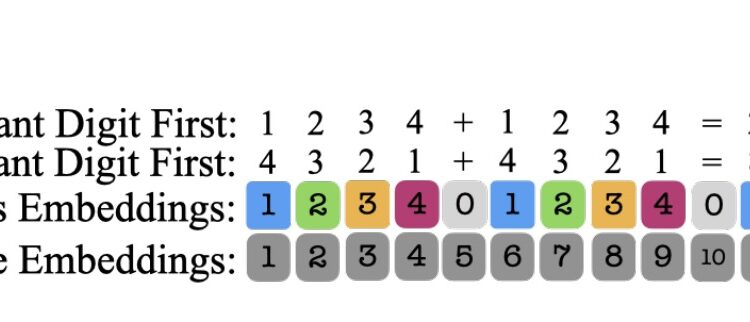

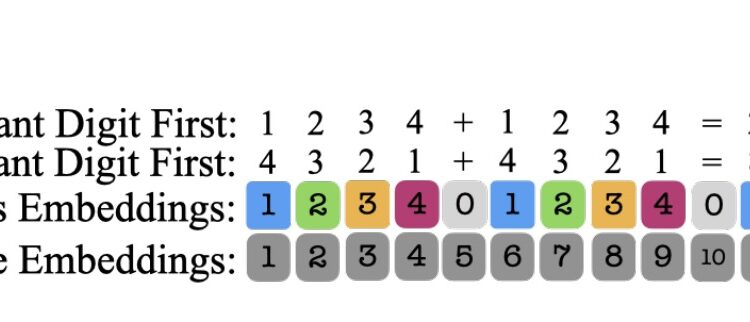

传统的transformer在处理长数字序列时,难以准确地跟踪和表示每个数字的位置,导致在进行多步骤和拿杂运算时性能不理想。 通过引入一种新的位置嵌入方法(Abacus Embeddings),研究人员显著提高了transformer处理复杂算术任务的能力。 使其在训练仅一天后,能够准确处理多达100位数的加法问题,并且这种改进也能推广到乘法和排序等其他多步骤推理任务。

传统的transformer在处理长数字序列时,难以准确地跟踪和表示每个数字的位置,导致在进行多步骤和拿杂运算时性能不理想。 通过引入一种新的位置嵌入方法(Abacus Embeddings),研究人员显著提高了transformer处理复杂算术任务的能力。 使其在训练仅一天后,能够准确处理多达100位数的加法问题,并且这种改进也能推广到乘法和排序等其他多步骤推理任务。