微软Build大会前脚刚放出一箩筐生产力革命最新进展:自定义Copilot、Team Copilot、Copilot扩展……

这两天在微软AI Day上,Copilot到底是如何提升生产力的,直接被搬到了台面上现场演示。

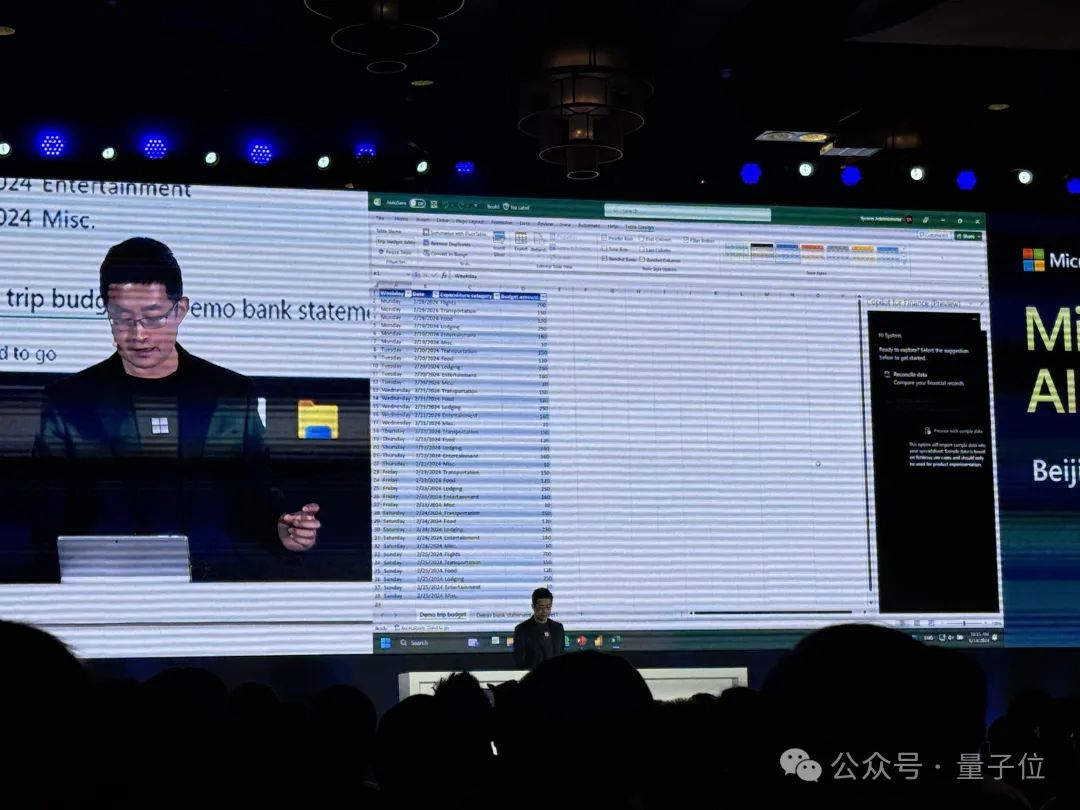

假设你的身份是一名公司财务,老板让你1分钟内完成报销核对,现在你有一个Excel,其中有公司报销单、银行账单这两个sheet,要如何在一分钟内迅速核对完?

别着急,打开具有Copilot for Finance的Excel账号,就会发现在菜单栏右侧多出了一个Copilot for Finance的图标:

接下来请看VCR:

微软亚洲区Microsoft Azure策略运营总经理康容表示:

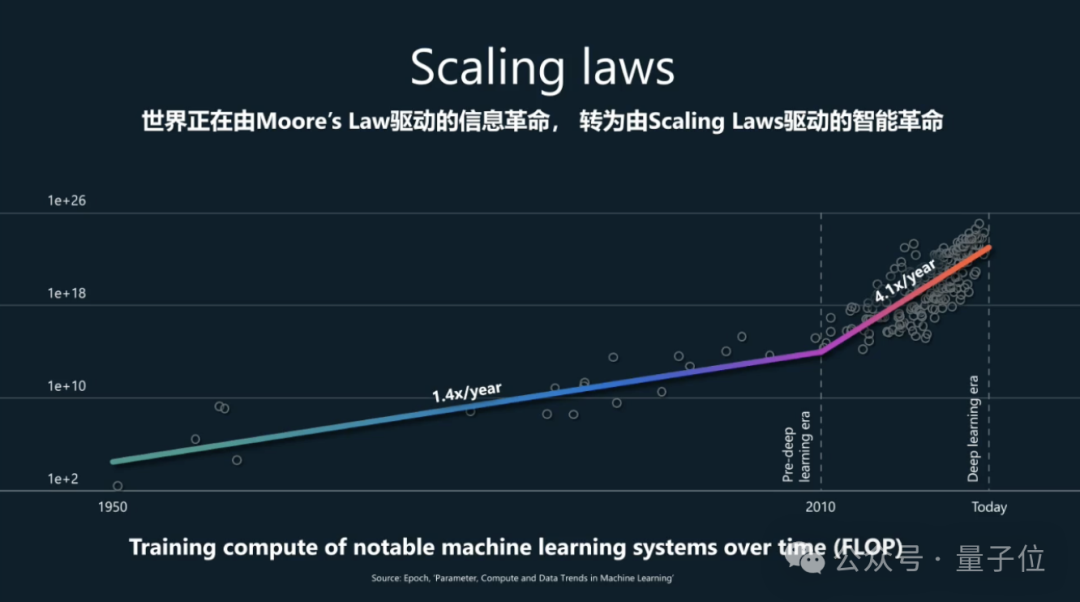

以生成式智能为代表的新一代AI技术创新正在加速演进,在今天的Scaling Laws下,AI技术的能力大约每六个月内就会翻倍增长。

与此同时,如何让技术成果对齐行业、企业的实际业务需求,加速技术能力的落地转化,助力更多客户加速智能化转型与创新,成为当前微软最关注的业务领域。

PS:

最新消息,微软还将与Cognition携手,把AI程序员Devin带给客户,来完成代码迁移和现代化项目等复杂任务。作为双方协议的一部分,Devin将由微软智能云Azure提供支持。

AI时代,报表可以帮老板写报表

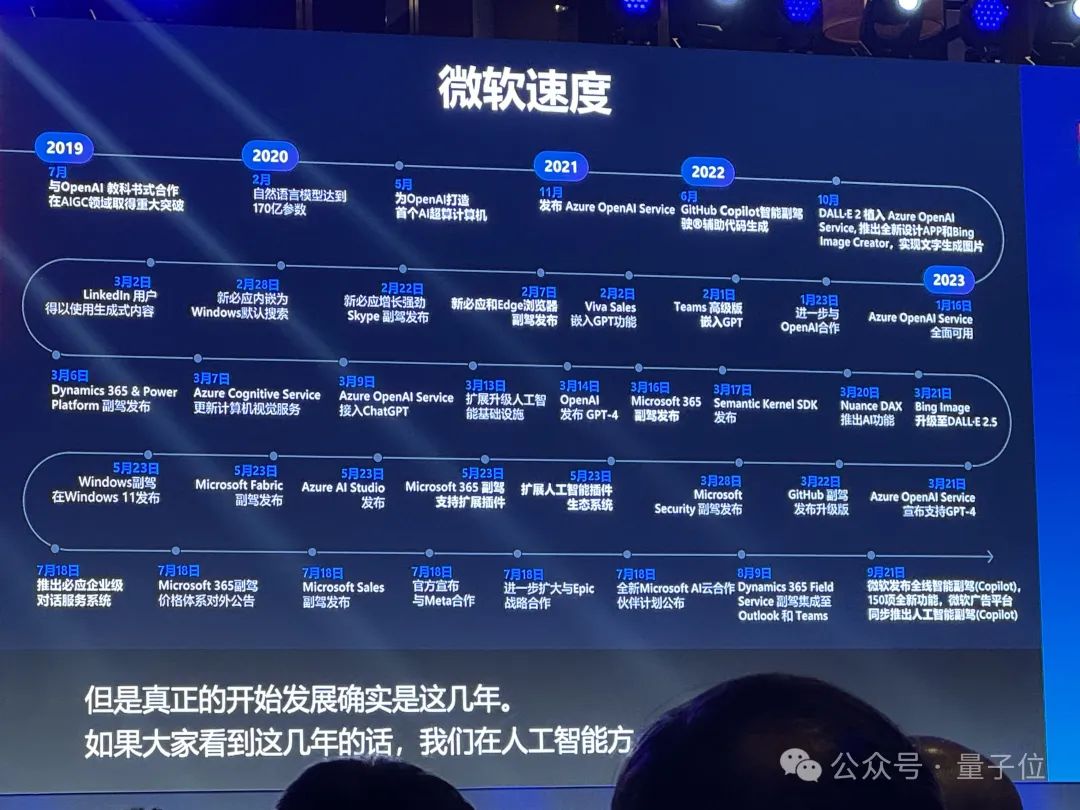

微软在北京举办的以“共创AI创新,智启无限可能”为主题的Microsoft AI Day活动中,集中展示了在生成式智能技术加速发展普及的过程中,微软取得的最新技术突破与进展。

并同步更新了在Microsoft Build 2024全球开发者大会上发布的一系列Azure AI新服务与新功能、加速壮大的Microsoft Copilot智能副驾驶(® )技术栈,以及用以帮助企业开发者打造专属Copilot智能副驾驶(®)的Microsoft Copilot Studio等一系列开发工具与平台服务等。

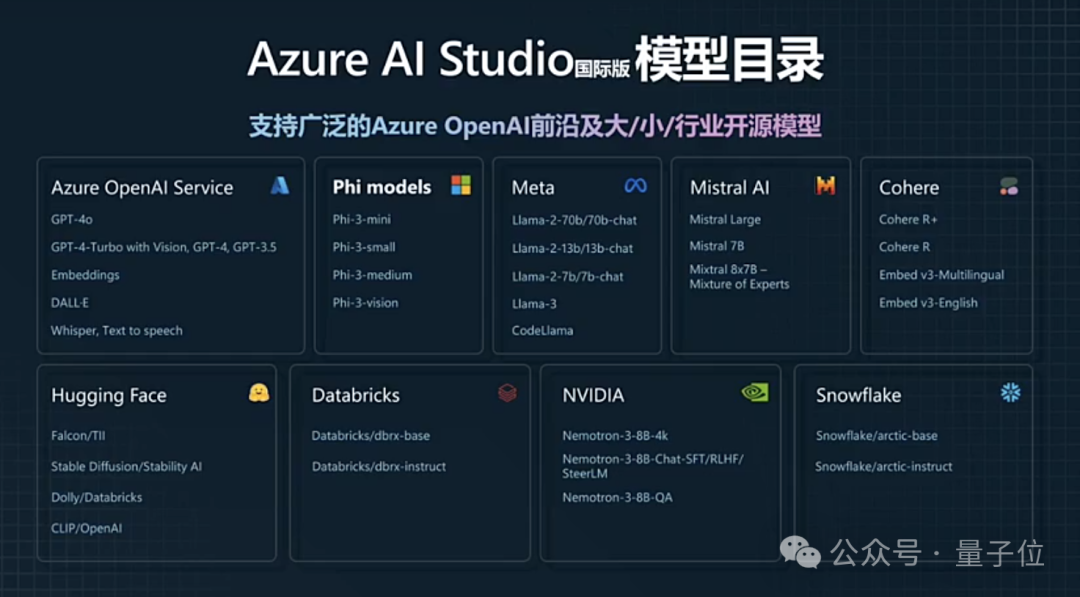

微软亚洲区Microsoft Azure策略运营总经理康容介绍,Azure AI方面,GPT-4o现已加入Azure AI Studio。

同时Azure AI Studio还提供Coherence、Databricks、Deci、Meta、Mistral AI、Snowflake等大模型服务支持。

微软开发的Phi-3系列“小”模型最新推出的全新多模态模型Phi-3-vision,也可使用。开发者还能在Azure AI Studio中构建和定制模型。

微软大中华区首席运营官陶然还在现场以OPPO手机为例,演示了端侧小模型的高效部署:

除此之外,陶然还展开分享了微软的Copilot愿景。

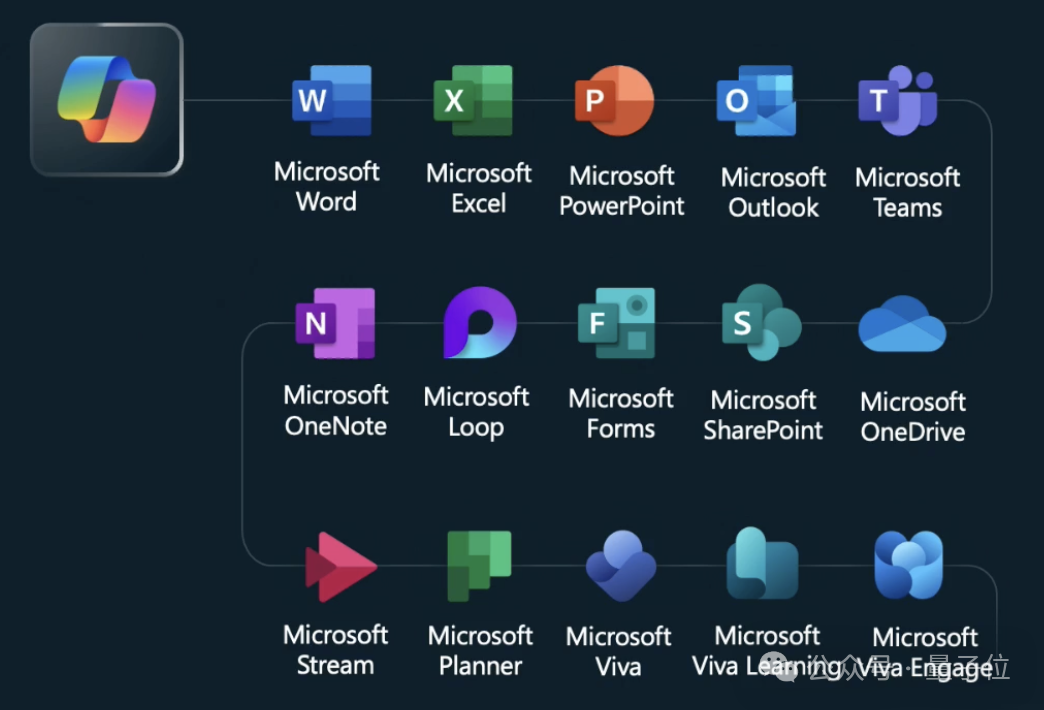

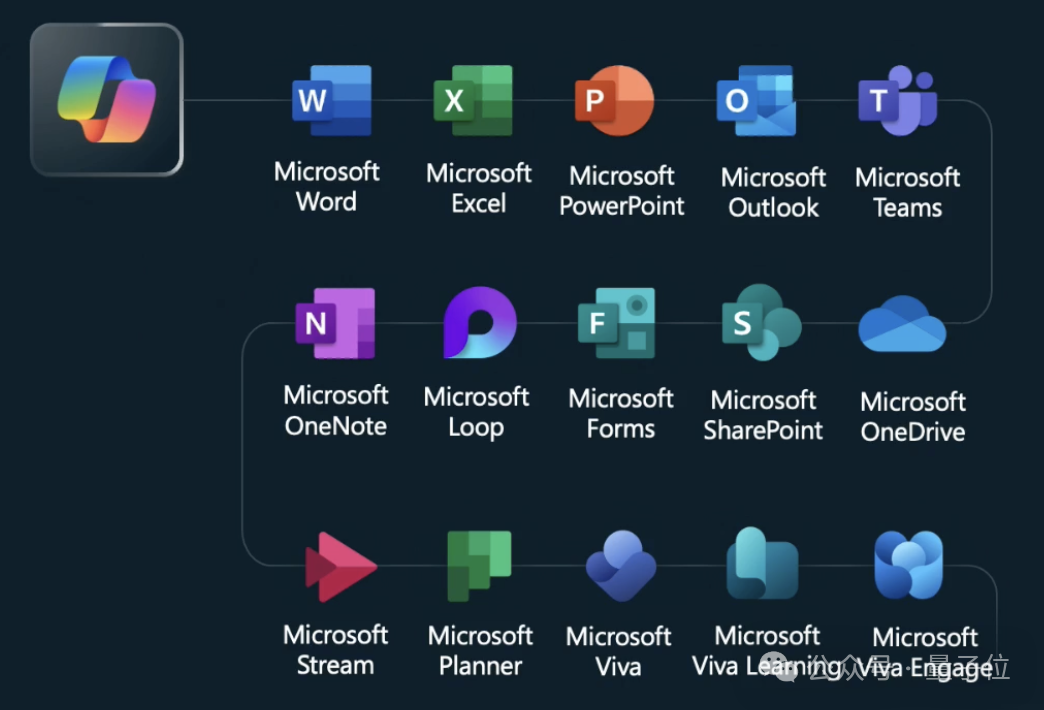

首先,Copilot是个人的智能副驾驶(®),微软用Copilot打通了自家办公产品线,让个人实现生产力的提升。

在此基础之上,微软的最终目的是让Copilot深入企业业务场景,实现部门级别的Copilot产品落地和业务能力的提升。

除了开头所展示的Demo,现场还展示了Copilot的更多功能,例如用Copilot做报表:

在AI时代,报表也可以帮老板写报表了。

继续来看VCR:

在众多服务基础之上,微软也透露了目前与企业的合作情况。

例如,携程采用Azure OpenAI服务为旗下Trip.com海外网站提供面向海外39个国家的多语言服务,为海外旅行者打造自动化客服机器人和邮件咨询系统,还进一步借助Azure OpenAI服务开发了高质量的智能旅行对话机器人TripGenie。

TripGenie能够自动搜索、整合Trip.com海外平台上的实时旅行线路、航班、酒店等信息,根据境外客户提出的旅行需求和预算,自动设计出最佳行程计划。

在微软支持下,TripGenie的构建周期仅用时两个月,目前可提供英、日、韩及繁体中文服务。

联想选择引入Dynamics 365 Sales作为全球统一的销售管理系统。

Dynamics 365 Sales能够整合不同来源的新老业务系统与业务流程,并集成了销售协作与AI功能,让全球70%的联想销售团队得以实时记录客户互动活动、即时共享销售信息,为客户提供更加主动、个性化的服务体验。

麦当劳中国选择微软为量身定制了整套智能化创新解决方案,包括由Azure云平台提供自然语言交互、生成式智能、机器学习等企业级的智能化服务;以融入Copilot智能副驾驶(®)的Microsoft 365为基础,构建高效的员工协作平台;通过GitHub Copilot智能副驾驶(®)加速IT开发和系统运维,提升IT系统及业务应用开发迭代效率等。

麦当劳中国南京创新中心成立“AI-Lab”,将智能技术引入麦当劳中国“汉堡大学”,为20万名员工提供职业发展与技术技能培训。

端上做应用,小模型又快又划算

会后,微软亚洲区Microsoft Azure策略运营总经理康容、微软大中华区首席运营官陶然回答了大家感兴趣的一些问题。

量子位在不改变原意的基础上,对部分问答进行了整理。

Q:您讲到Scaling Laws,参数越多性能越好。那对于小模型,怎样能达到很好的推理能力?主要的原理是什么?

陶然:第一,我们在云端大模型开放兼容并蓄;第二,在端侧其实很多场景都需要用小模型的能力。您刚才讲Scaling Laws也好,性能也好,随着时间的演变和算力不断加持,以及我们对于数据和算法的调优,它的质量肯定是稳步提升。

大模型在往前走,但微软研发的Phi小模型为什么能够实现用更低的成本和更小的size实现更高的质量?

第一个关键在于算法,微软有几十年的技术研发实力。

第二是数据质量,微软采取了一个Synthetic Data的训练模式。通过和高质量,甚至是超高质量合成数据去实现Phi的小模型,用更小的size实现更高的性能。

在微软看来,小模型的场景正在不断分化。小模型并不是说,只帮我写诗、作画就够了。小模型也可以有多模态,也可以变成行业定制的模型。小模型和行业数据和企业业务场景的集成即将会变成更多的强需求。

Finetune一个大模型非常痛苦,有的时候也不一定达到效果。但小模型不一样,企业业务数据可以更加高效实现常用场景下的Finetune,以及一些更好的embedding。

然后是复杂场景,比如真的是需要Agent,继续交给云端大模型去完成。但是也可以把重用、常用、高频、低延迟的场景交给小模型,这就是我们现在看到的行业发展的一些趋势。

康容:我完全同意陶然讲的。不是小模型是不是会把大模型取代的问题,而是我们认为未来会有多模型的合作。各个模型有不同的优势。

比如没有网络的场景,肯定小模型有优势。而对于非常复杂的项目或场景,要做大量自然语言翻译,就要走大模型那一步,消耗大量的数据去理解,小模型“吞”不了那么多。如果你要快速在端上做基本的应用,小模型又快又划算。

Q:Copilot Studio最近推出新功能可以自定义Agent,底层用的哪些技术?

陶然:Copilot Studio不是一夜之间出现的全新独立技术产品,而是基于微软过去几十年在商业应用领域的云端的Business Applications积累快速迭代、快速生成的结果,比如Dynamics365 for Sales、for Finance、for Operation,传统意义上理解的云端CRM、云端的ERP、云端HR系统,这些系统让微软可以快速打造Copilot。

基于我们对企业业务流程、数据、系统的理解,可以快速找到企业如何把核心的CRM、ERP、财务的系统做智能化改造的方法,很多企业都是在这个基础上连接AI的layer。

Copilot Studio就是基于这样的基础框架实现产品的研发和迭代。产品背后本身集成三大核心能力:第一,微软ERP、CRM和云端Dynamics365的能力;第二,结合了OpenAI大模型能力;第三,结合对于Agent、Copilot生态的理解以及生态的渗透。

Q:对于大模型在企业落地,一种思路是把大模型的能力跟企业私有数据结合,另外一种思路是用小模型,也就是Phi-3的思路。您认为哪种思路更好?

陶然:微软全球和微软中国每天与众多客户探讨大模型的应用落地。根据我们的观察,没有哪种技术路线是绝对对或错的,关键在于是否适用以及相应的成本。

大模型与企业数据的集成是一个平衡的决策过程,需综合考虑成本、数据质量、数据量、模型的成熟度和复杂度等因素。如果企业预算充足,当然可以不计成本地购买数据、进行训练和推理。

康容:甚至训练自己的大模型。

陶然:企业都希望以高效且成本可控的方式实施方案,但这需要实际评估。

例如,若客户希望对GPT模型进行微调,但只有一万行数据,对于拥有1750亿参数的GPT模型而言,一万行数据无法显著影响其推理过程,因此无法实现预期效果。然而,如果通过添加企业数据集,如RAG技术,就能在大模型进行数据输入和输出时,整合企业数据集并生成Embedding数据集。

微软提供了多种技术选择,例如在全球范围内开源的Semantic Kernel,任何企业都可以通过编程实现RAG和Embedding数据集成,并通过微软网站下载使用。

同时,微软也支持开源,可以使用第三方开源的RAG模型和编程开发SDK。最终,我们需要讨论数据量和数据质量的问题。如果国内客户有此类需求,微软中国可以帮助客户进行实际评估,选择成本和效能最优的技术路线,以推进项目进展。

Q:小模型相比大模型有何优劣?

陶然:同样去做Embedding与Fine-tuning,小模型的成本大多情况下比大模型低。

应用场景是关键,如果希望小模型帮忙完成写诗作画,可以把企业内部写诗作画的信息导入,然后它就可以根据上下文完成任务。

小模型跟大模型有能力上的差异,比如微软的Phi-3,虽然我们尽可能把它的每一个能力象限往往前延申,但跟GPT4、GPT4o相比,肯定有些地方是缺失的。

针对不同场景有的放矢去做一些Embedding和Fine-tuning、RAG,可以更加事半功倍。小模型和大模型一样,第一,可以定制化和集成;第二,定制化集成的东西可以到设备里去;第三,找到合适的场景。