让AI画漫画角色保持一致的新研究来了!

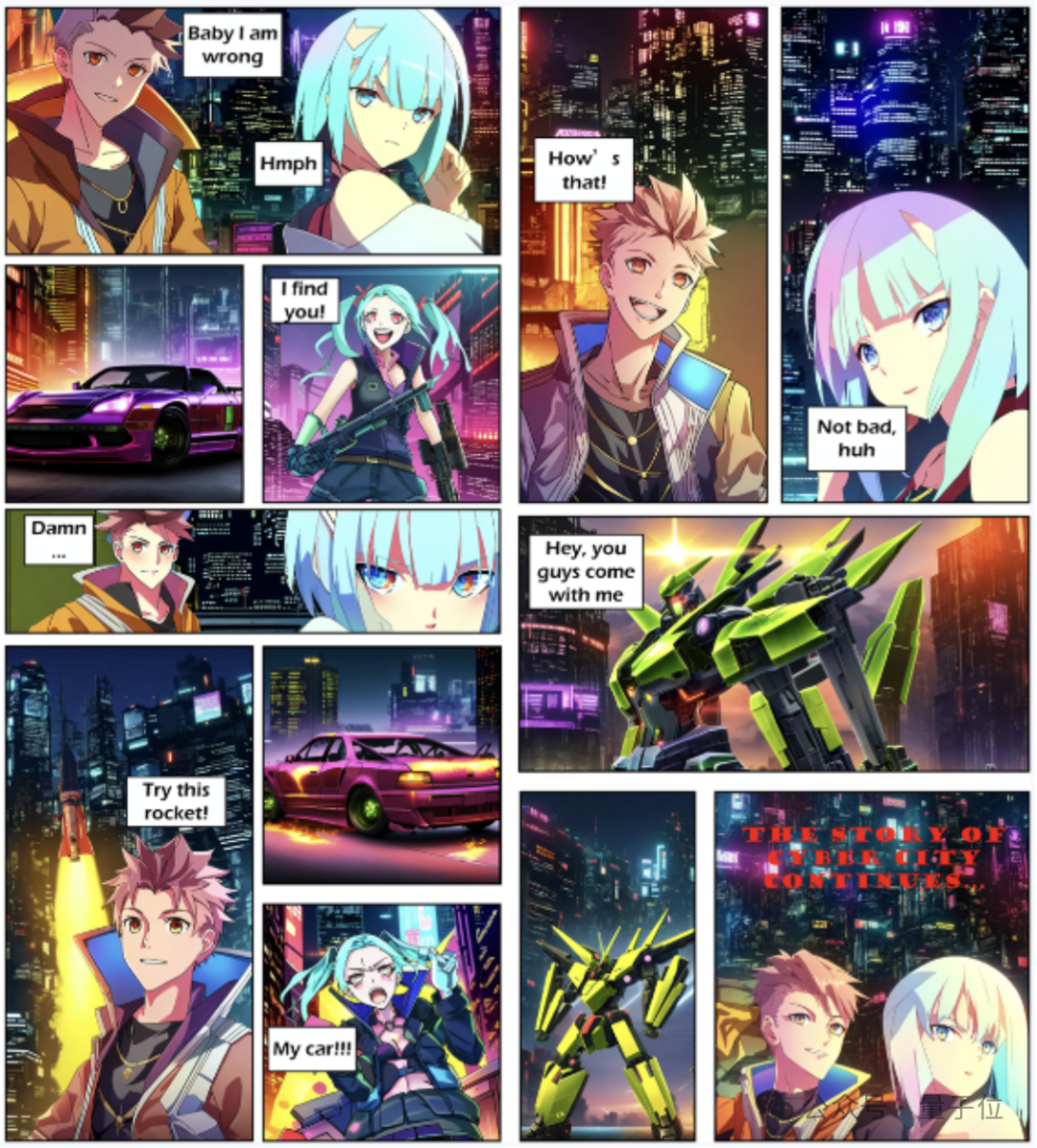

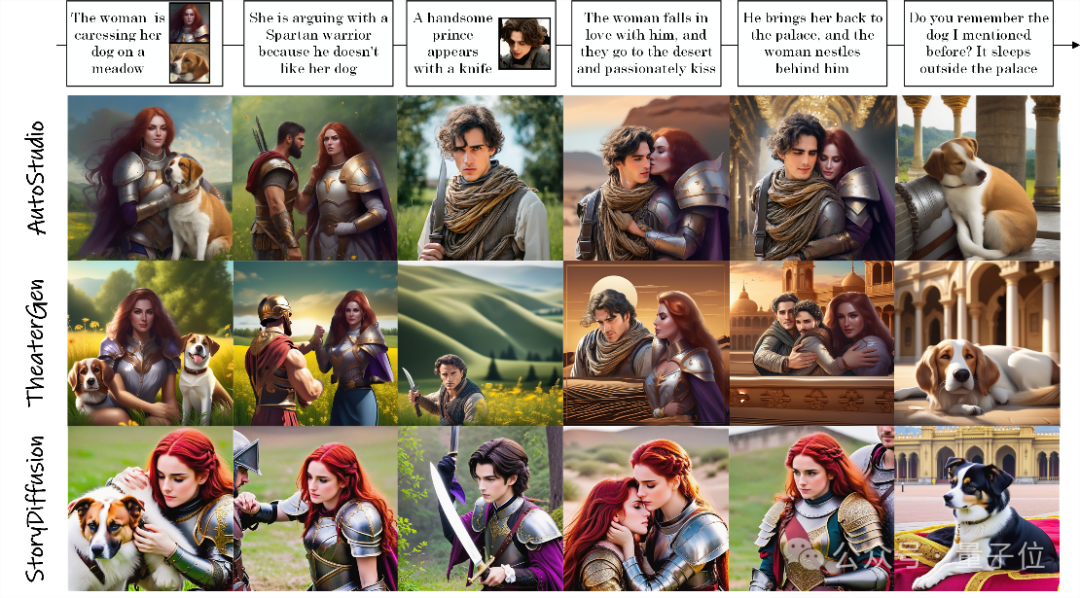

创作的连环画效果belike:

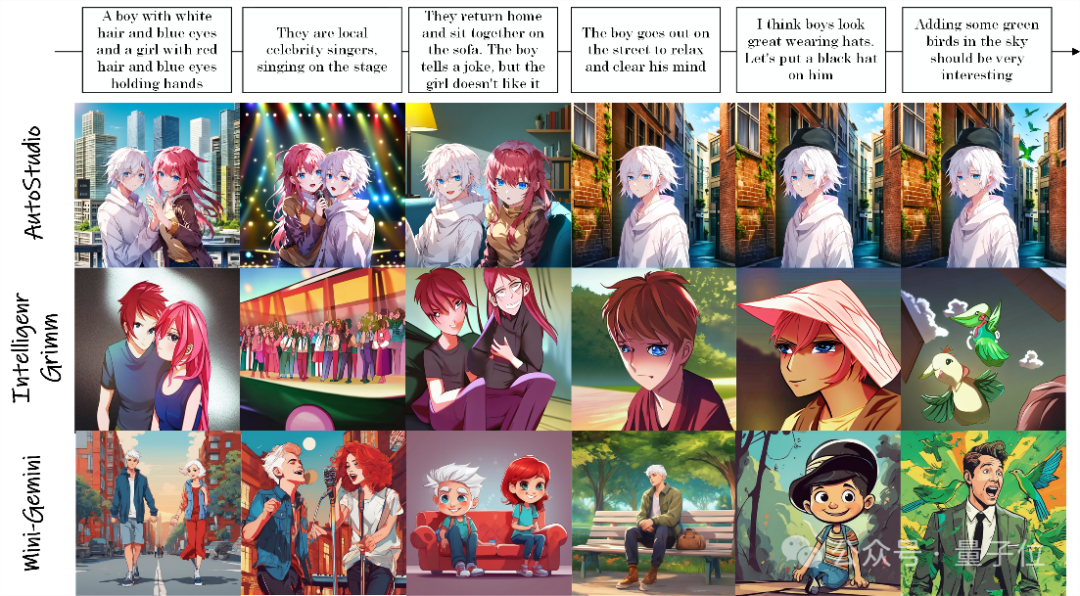

频繁切换主体、人物之间复杂的互动也能保持角色一致性:

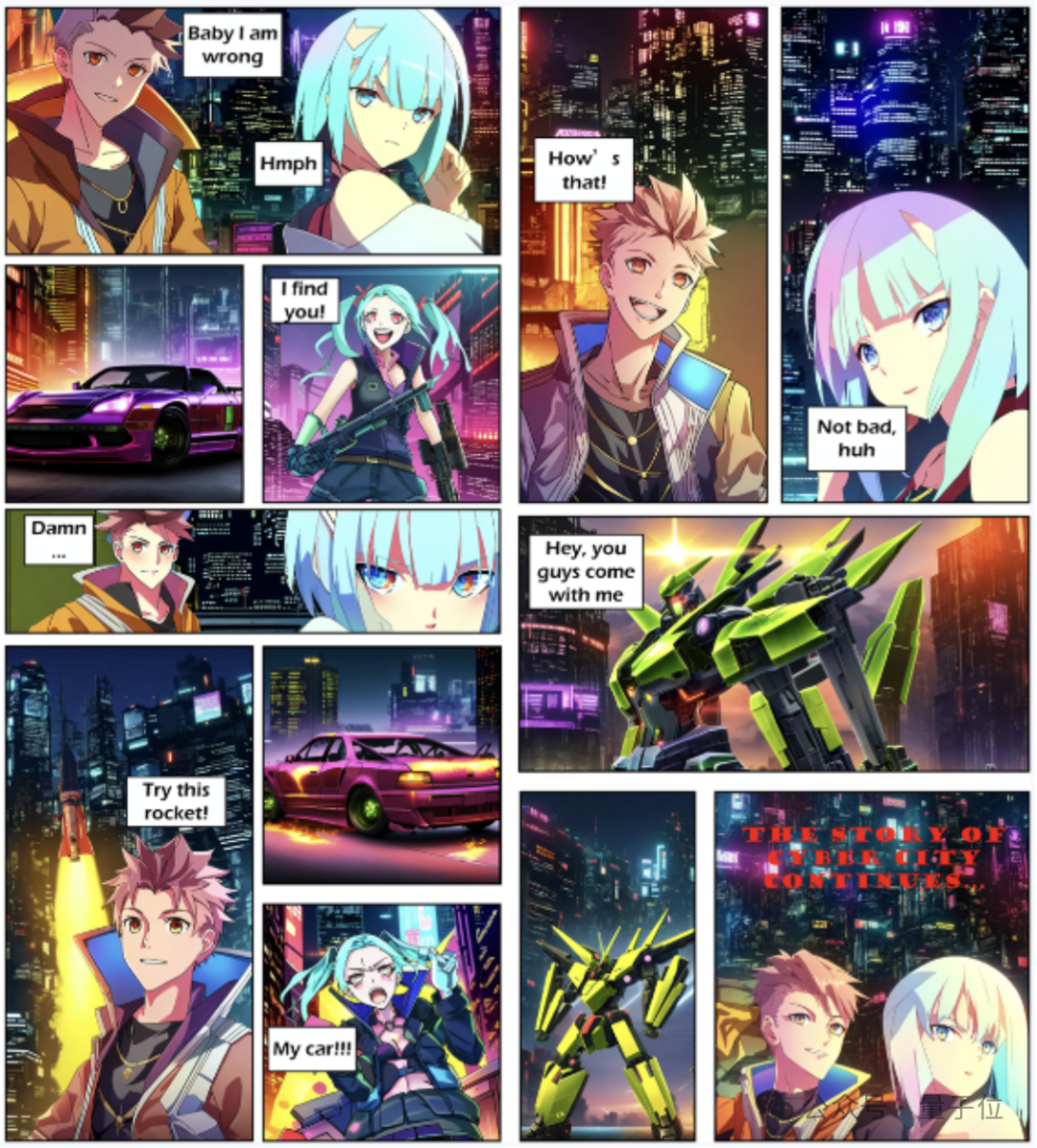

上述效果来自AutoStudio,是一个由中山大学和联想团队联合提出的无需训练的多智能体协同框架。

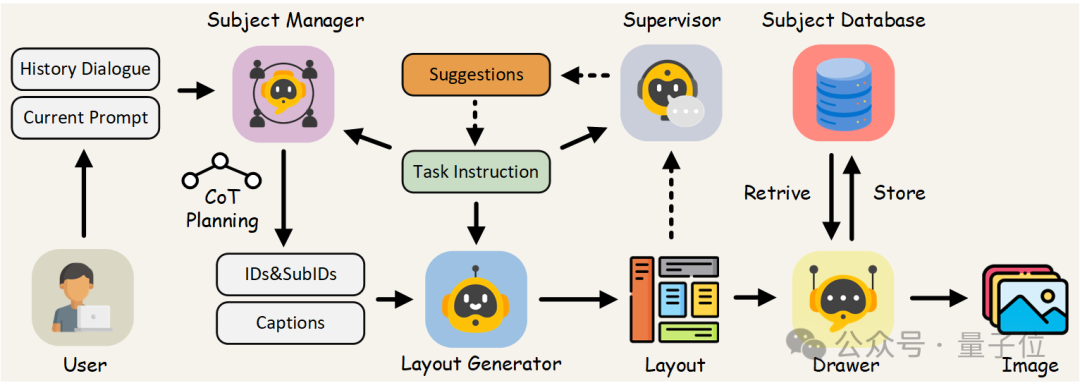

AutoStudio采用基于大语言模型的三个智能体来处理交互,并使用基于扩散模型的Drawer生成高质量图像。

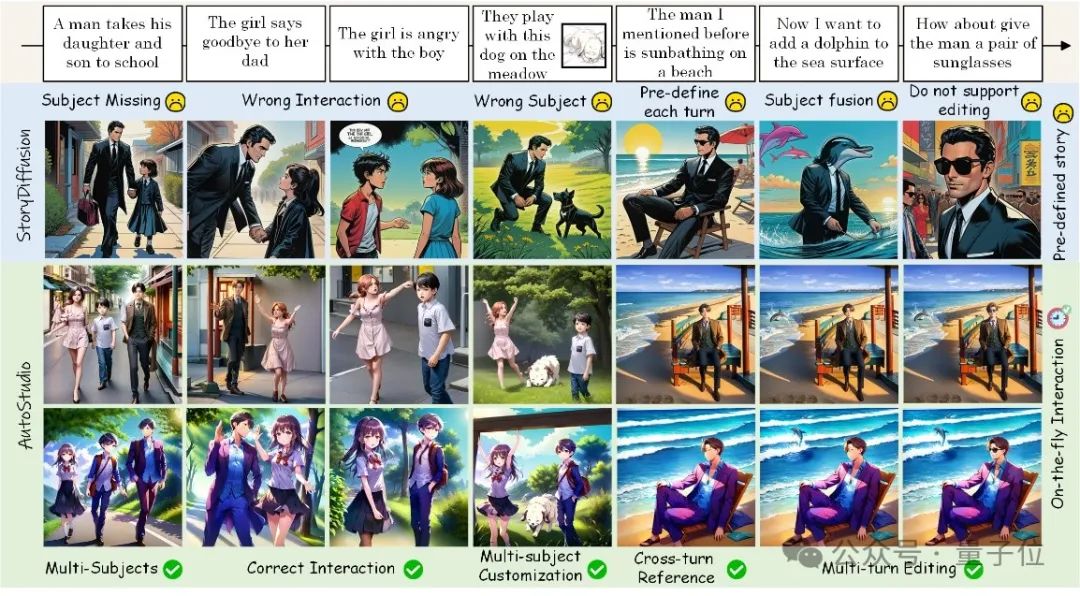

实验中,AutoStudio无论是在定量还是定性评估中都优于现有方法。

AutoStudio长啥样?

由于最先进的T2I生成模型在生成令人印象深刻的单个图像方面表现出了卓越的能力,研究界对更复杂的多轮交互式图像生成工作的兴趣与日俱增。

在现实世界的应用中,用户经常需要以交互方式生成一系列图像,其中包括各种任务,如开放式故事生成和多主体多轮编辑。

然而,目前的方法大多数要求预先定义所有轮的生成指令,并且在面对不同的用户指令(如定制、编辑和大量交叉引用)时,很难在多个主体之间保持一致性。

为了解决这些问题,研究团队引入了AutoStudio,这是一个多智能体、无需训练的框架,具有四个特别定制的智能体,利用现成的模型与用户进行即时交互。

他们的目标是引入一个多功能、可扩展的框架,通过多智能体协作,可以将任何所需的LLM架构和扩散骨干结合到框架中,以满足用户多轮生成的多样化需求。

具体而言,AutoStudio包括三个基于LLM的智能体:

- 主题管理器解释对话,识别不同的主题,并为其分配适当的上下文;

- 布局生成器为每个主题生成部分级别的边界框,以控制主题的位置;

- 监督员为布局生成器提供布局改进和修正的建议。

最后,绘制器基于扩散模型完成基于改进布局的图像生成。

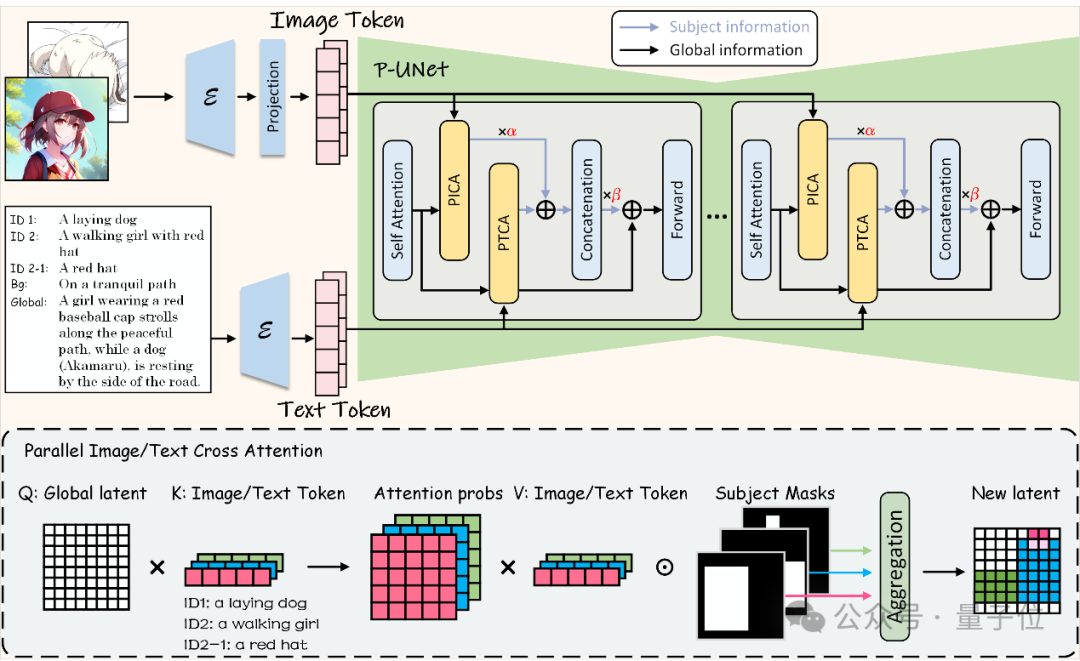

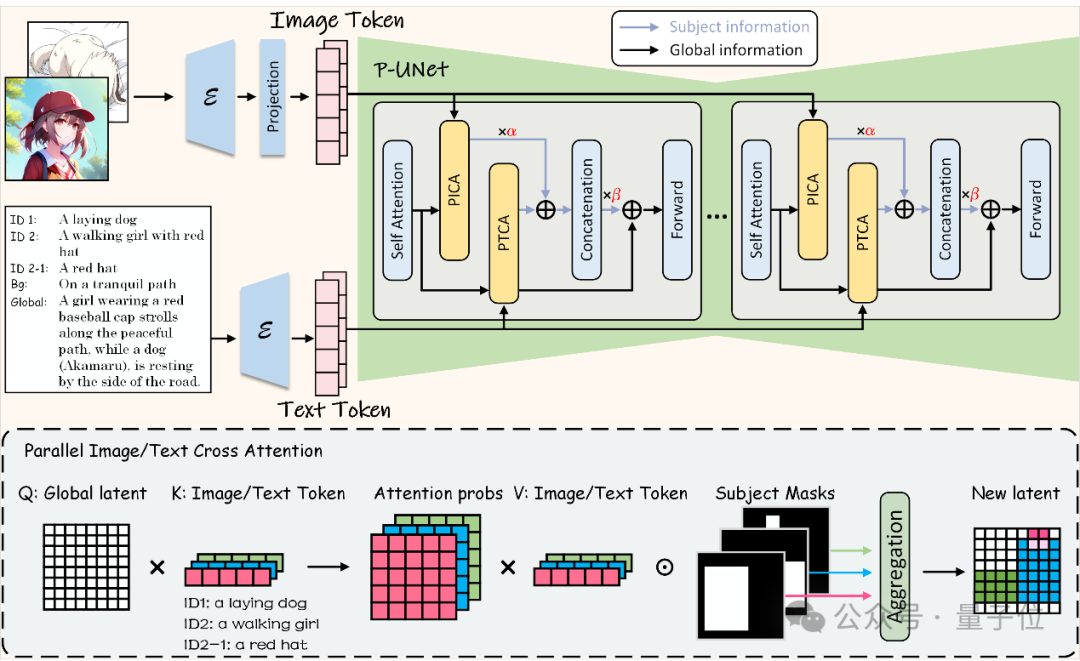

此外,研究人员在绘制器中引入了一个并行UNet(P-UNet),它具有一种新颖的架构,利用两个并行的交叉注意力模块分别增强文本和图像嵌入的潜在主题特征。

为了进一步解决SD在理解长提示和生成过程中缺失和错误融合主题的限制,研究人员在绘制器中引入了一种主题初始化的生成方法。

接下来是对AutoStudio架构的详细说明。

多智能体协同

研究团队首先引入一个主题管理器Manager,它不仅能为主题及其组件分配ID,还能将用户提示转换为绘图说明。

然后,布局生成器Layout Generator对这些标题进行处理,生成粗略的布局,其中包含每个主题及其组件的边界框和信息。

为了纠正不合理的主体内和主体间空间关系并完善粗略布局,引入了一个监督器Supervisor。

该监督器将粗布局作为输入,并向布局生成器提供建议。

通过这种方式,Supervisor和Layout Generator密切协作,形成一个布局细化的闭环流程。

此外,研究团队还定义了一组任务介绍,以指导这三个基于 LLM 的代理生成格式正确的响应。

最后,给定细化布局和从主体库中获取的主体信息,绘图器Drawer可以生成与布局对齐且包含一致主体的图像。

主体初始化生成过程

为了解决多ID绑定任务中主体丢失和融合的问题,研究人员引入主体初始化生成过程。

这个过程包括对主体粗粒度特征的单独生成,使用提取器提取特征并通过正向扩散映射到潜空间并在全局生成的初始几步进行局部替换。

P-UNet

Stable Diffusion模型中的原始UNet利用交叉注意模块来利用文本特征,但这不足以表示多个主体的空间关系和特征。

因此,研究人员提出了利用免训练布局调整注意力模块的P-UNet。

将UNet层的原始交叉注意模块拆分为两个并行的文本和图像交叉注意模块(分别称为PTCA和PICA)来细化Z,这两个模块具有相同的架构,其主要思想是计算Z与每个主体文本/图像嵌入之间的特征相似性。

AutoStudio效果如何?

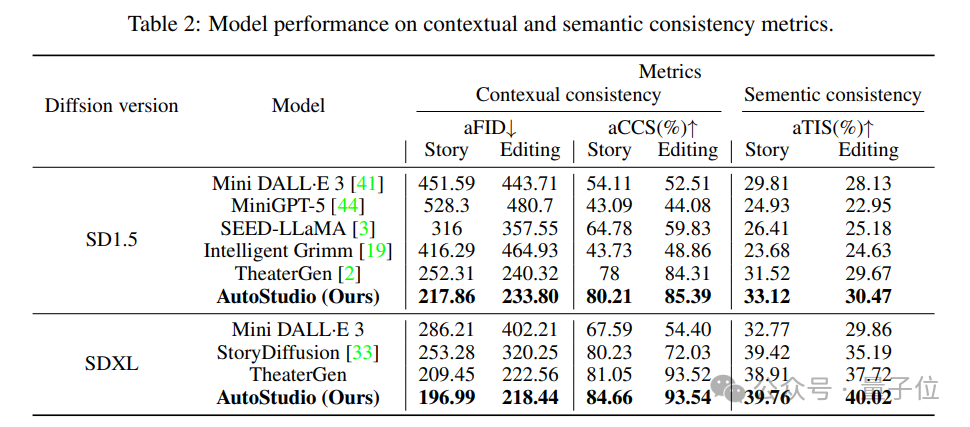

研究人员在CMIGBench上利用所选的基准模型对AutoStudio进行了全面评估。

CMIGBench基于故事生成和多轮编辑,包含8000个多轮脚本对话(每个任务4000个)。

研究人员选择了平均弗雷谢特起始距离(aFID)和平均字符-字符相似度(aCCS)这两个定量指标来评估上下文一致性,并选择了平均文本-图像相似度(aTIS)来评估主体间的语义一致性。

结果,AutoStudio在所有指标上都明显优于之前的方法。

下图展示了多轮交互式图像生成的可视化结果,表明AutoStudio能够理解用户的自然语言指令,并生成主题一致的图像。

相比而言,Theatergen无法处理人物之间复杂的互动(如拥抱和接吻),而MiniGemini则难以保持主体的一致性。

Intelligent Grimm和StoryDiffusion无法在多回合互动中保持多个角色之间的一致性,并表现出有限的编辑效果。

论文链接:https://arxiv.org/abs/2406.01388

项目主页:https://howe183.github.io/AutoStudio.io/